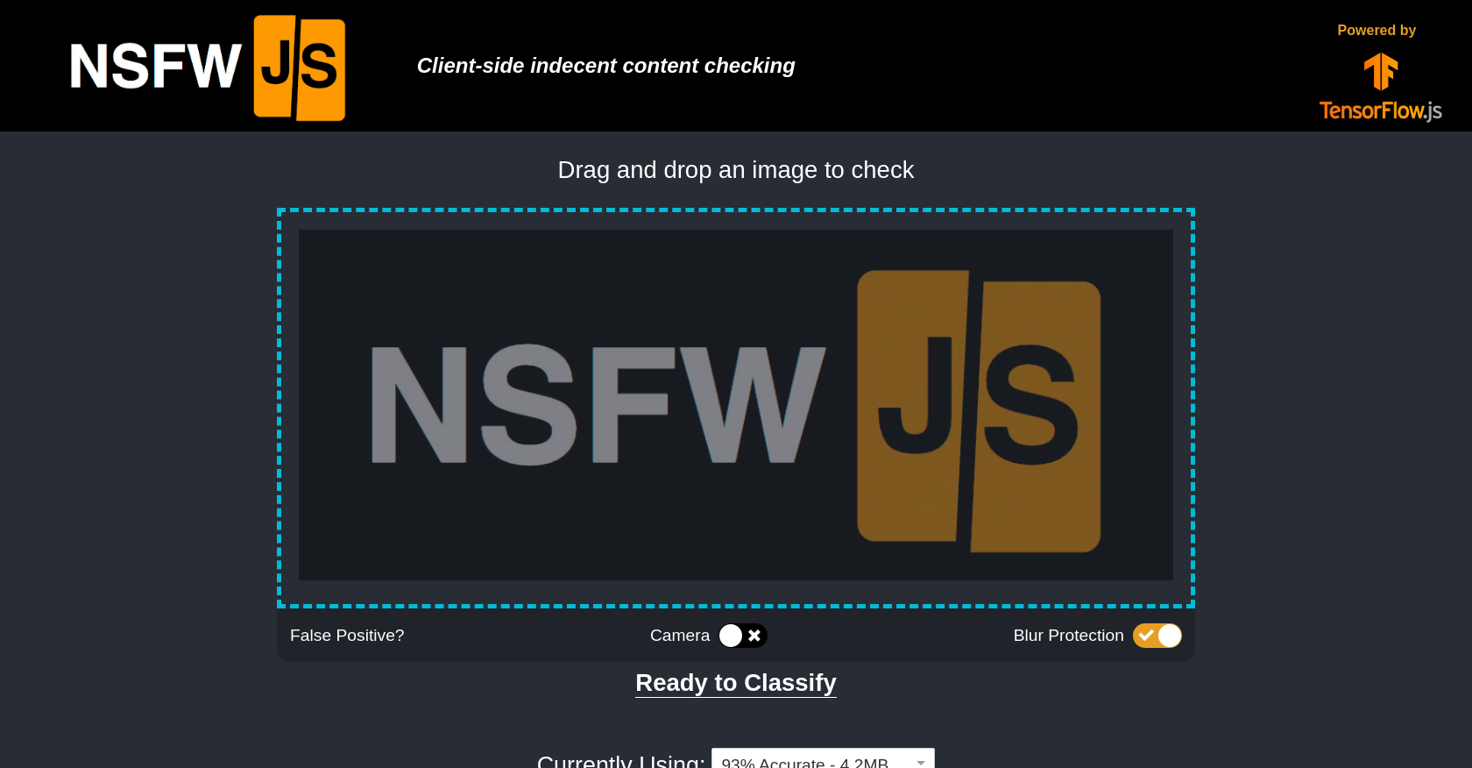

Ein neues JavaScript-Library namens NSFW JS verspricht eine innovative Lösung für die Identifizierung potenziell unangemessener Bilder direkt im Browser des Nutzers. Ohne Daten an einen Server zu senden, analysiert die KI-Software mithilfe von TensorFlowJS Muster in den Bildern und erkennt potenziell problematische Inhalte mit einer Genauigkeit von 93%.

Ein Auge für die Unangemessigen

Besonders bemerkenswert ist die integrierte "CameraBlur Protection"-Funktion. Sobald NSFW JS ein Bild als möglicherweise unangemessen identifiziert, wird es automatisch verwischt. Dies bietet Nutzern einen zusätzlichen Schutz vor unbeabsichtigtem Zugriff auf sensiblen Inhalten. Die Entwickler von NSFW JS betonen die kontinuierliche Weiterentwicklung des Systems. Neue Modelle werden regelmäßig veröffentlicht und das System lernt ständig aus den Daten der Nutzer.

NSFW JS ist Open-Source und kann kostenlos genutzt, modifiziert und unter der MIT-Lizenz verbreitet werden. Ein mobiler Demo-Bereich ermöglicht es Nutzern, verschiedene Bilder auf ihren mobilen Geräten zu testen. Der Quellcode steht über GitHub zum Download bereit und die Entwickler ermutigen Nutzer, Fehlalarme zu melden und an der Weiterentwicklung des Projekts mitzuwirken.

NSFW JS bietet eine vielversprechende Lösung für die sichere Nutzung von Bilddaten im Internet. Durch die lokale Analyse und den Schutz vor unbeabsichtigtem Zugriff auf sensible Inhalte trägt das Projekt zur Schaffung eines sichereren Online-Umfelds bei.

Überzeugen Sie sich selbst von diesem KI-Tool: